Apple spinge l’IA oltre i limiti: ora può “vedere” le nostre azioni anche senza una telecamera

Apple ha svelato uno studio che sembra uscito direttamente da un futuro in cui i dispositivi non guardano più… ma intuiscono.

Secondo i ricercatori dell’azienda, i moderni modelli di intelligenza artificiale sono ormai in grado di capire cosa sta facendo una persona anche senza una fotocamera, basandosi solo su suoni, vibrazioni e micro-movimenti del corpo.

È un concetto radicale che ribalta l’idea stessa di computer vision: non servono più occhi, basta ascoltare e interpretare.

Quando l’IA “vede” attraverso sensori e suoni

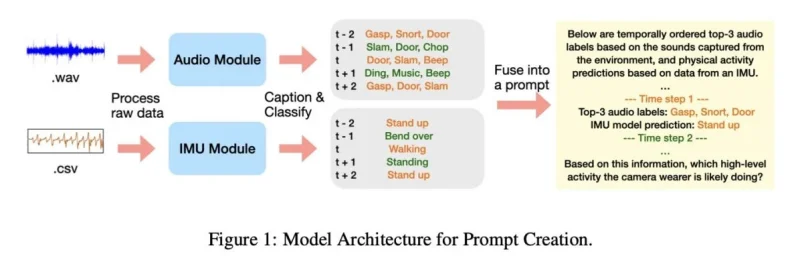

Nel paper, dal titolo “Using LLMs for Sequential Multimodal Sensor Fusion for Activity Recognition”, i ricercatori descrivono un esperimento sorprendente.

Un modello linguistico—senza alcun addestramento specifico sull’attività fisica—riceveva:

- registrazioni audio parziali,

- brevi descrizioni generate da altri modelli,

- dati provenienti da accelerometri e giroscopi.

Nonostante l’assenza di immagini, l’IA riusciva a ricostruire con buona precisione cosa la persona stava facendo in quel momento.

Lo studio ha utilizzato il celebre dataset Ego4D, un enorme archivio di scene quotidiane: dai lavori domestici allo sport, dai momenti di svago ai compiti più comuni.

Per l’esperimento, Apple ha isolato frammenti di 20 secondi che includevano attività come cucinare, aspirare, fare esercizio, leggere, lavorare al PC, accudire animali domestici, guardare la TV e giocare a basket o calcio.

Leggi anche:

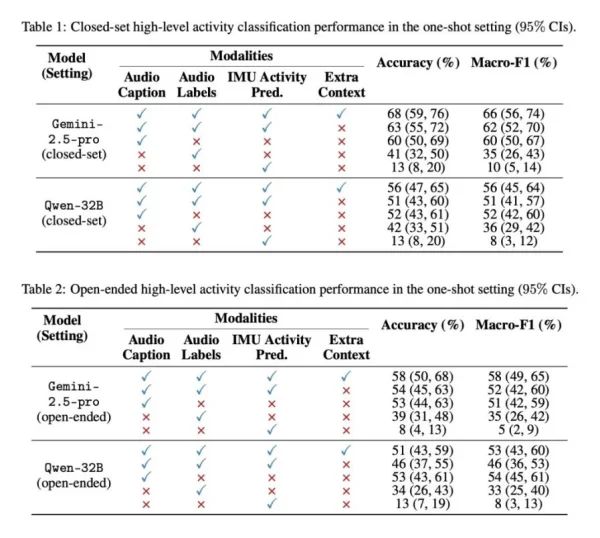

Gemini 2.5 Pro e Qwen-32B sorprendono: riconoscimento accurato anche in modalità “open”

Dopo aver generato descrizioni testuali dai sensori, queste informazioni venivano passate ai modelli Gemini-2.5-Pro e Qwen-32B.

I ricercatori hanno testato due modalità:

- closed-set, dove l’IA doveva scegliere l’attività esatta da una lista di 12 possibilità;

- open-set, senza alcun suggerimento o opzione predefinita.

In entrambi gli scenari, i risultati sono stati sorprendentemente alti, con una precisione fino al 58% anche senza input visivi. Per l’activity recognition è un dato notevole: è come chiedere a una persona di capire cosa sta accadendo in una stanza… senza poterla vedere.

Un futuro in cui smartphone e wearable capiranno tutto ciò che facciamo

È facile immaginare dove Apple voglia arrivare.

Un sistema così avanzato potrebbe trasformarsi in un monitoraggio intelligente del benessere, capace di comprendere se stiamo facendo attività fisica, lavorando, riposando, cucinando o compiendo movimenti potenzialmente rischiosi.

Il tutto senza videocamere, senza riprese, senza immagini.

Uno scenario interessante per la privacy, ma anche inquietante per la precisione con cui l’IA riesce a seguire le nostre abitudini partendo da pochi segnali invisibili.

Secondo gli autori dello studio, il futuro dell’AI passerà proprio da qui: l’integrazione di dati multisensoriali in grado di dare una “visione mentale” delle nostre azioni, con applicazioni che andranno dal fitness alla sicurezza, dalla domotica all’assistenza sanitaria.

E il fatto che i modelli ci riescano già oggi, senza addestramento visivo, suggerisce che il prossimo salto tecnologico sarà molto più vicino di quanto immaginiamo.

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Che ne pensi di questa notizia? Lascia un commento nell’apposita sezione che trovi più in basso e se ti va, iscriviti alla newsletter.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo [email protected].

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.