Google apre la strada a dispositivi quantistici scalabili e tolleranti ai guasti

Dimostrando che è possibile ridurre i loro errori in modo esponenziale.

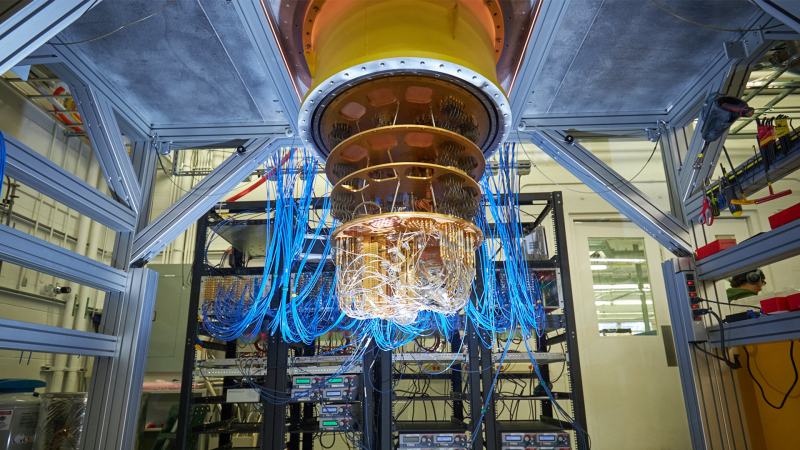

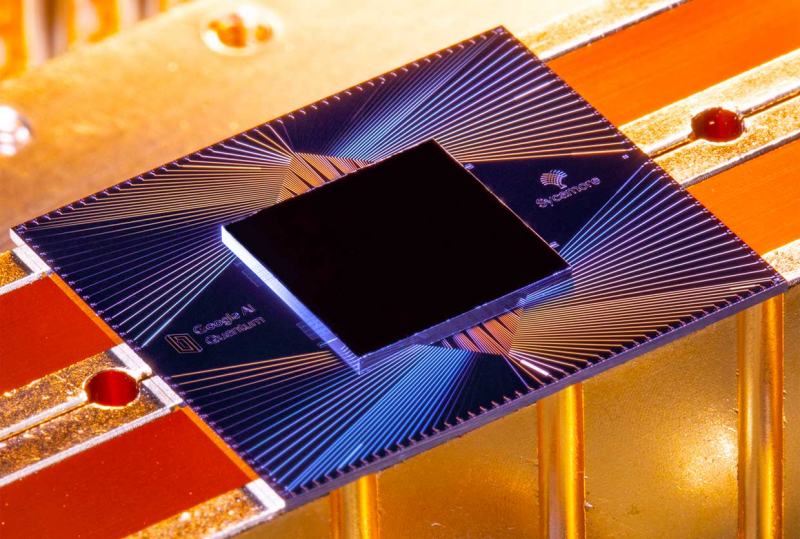

Le aziende di informatica quantistica si stanno unendo per farne una delle prossime grandi rivoluzioni IT. Quindi, dopo che la startup olandese QuantWare ha lanciato il primo processore quantistico superconduttore commerciale al mondo (QPU) soprannominato Soprano all’inizio di questo mese, Google a sua volta ha annunciato un processo che può ridurre drasticamente i tassi di errore nei computer quantistici. Il metodo è stato testato con il computer quantistico Sycamore dell’azienda ed è un ulteriore passo avanti verso la costruzione di un computer quantistico tollerante ai guasti.

Qual è la nuova scoperta di Google?

Ci si aspetta che i computer quantistici risolvano problemi che i computer di oggi non possono. Hanno più potenza di calcolo rispetto ai computer convenzionali. Quindi l’informatica quantistica promette di aumentare drasticamente la quantità di dati che i computer sono in grado di elaborare, il che potrebbe avere enormi ramificazioni in aree come la medicina, la business intelligence e la sicurezza informatica. Ma l’industria quantistica è ancora giovane e scalare è difficile. Tuttavia, molte aziende promettono scoperte nel corso di questo decennio.

Un computer quantistico con un numero sufficiente di componenti “qubit” potrebbe in teoria ottenere un “vantaggio quantistico” che gli consente di trovare le risposte a problemi che nessun computer classico potrebbe mai risolvere. Tuttavia, uno dei principali svantaggi dei computer quantistici di oggi è che il loro funzionamento interno è soggetto a errori. Le attuali piattaforme quantistiche avanzate hanno tipicamente tassi di errore vicini a 10 ^ -3 (o uno su mille), ma molte applicazioni pratiche richiedono tassi di errore fino a 10 ^ -15.

Oltre a creare qubit fisicamente meno soggetti a errori, gli scienziati sperano di compensare tassi di errore elevati utilizzando codici stabilizzatori. Questo processo prevede la distribuzione di informazioni quantistiche su molti qubit in modo che gli errori possano essere rilevati e corretti. Un gruppo di questi “qubit di dati” può quindi contare come un singolo “qubit logico” utile. Sebbene i principi dei codici stabilizzatori siano stati applicati teoricamente a piattaforme diverse, non è stato dimostrato che il metodo possa essere applicato a sistemi di grandi dimensioni.

Leggi anche:

Secondo Google, inoltre, non è stato dimostrato che resista a più cicli di correzione degli errori. In questo nuovo studio, gli scienziati del gigante di Mountain View hanno prima sperimentato un tipo di codice stabilizzatore noto come codice di ripetizione, in cui i qubit di Sycamore, il computer quantistico a 54 qubit di Google, servivano alternativamente. per rilevare gli errori dei loro colleghi. Gli scienziati hanno organizzato questi qubit in una stringa unidimensionale, in modo che ogni qubit avesse al massimo due vicini.

I ricercatori hanno scoperto che l’aumento del numero di qubit su cui è costruito il loro codice di ripetizione ha comportato una soppressione esponenziale del tasso di errore, riducendo il numero di errori per ciclo di correzioni fino a più di cento volte quando hanno aumentato il numero di qubit da da 5 a 21. È stato dimostrato che questa soppressione degli errori è stabile su 50 cicli di correzione degli errori. “Questo lavoro sembra convalidare sperimentalmente l’ipotesi che i sistemi di correzione degli errori possano evolversi come previsto”, ha affermato l’autore principale Julian Kelly, ricercatore di Google.

Prossimo passo: migliorare il metodo ed estenderlo

Naturalmente, l’esperienza ha ancora enormi limiti. In effetti, come spiegato sopra, il team ha testato il metodo con diverse dimensioni di qubit logici per ottenere un cluster massimo di 21 qubit, che ha ridotto l’errore logico di oltre 100 volte rispetto ai cluster composti di soli 5 qubit. In altre parole, più grande è il qubit logico, meglio gli errori possono essere corretti. Questo è importante perché i computer quantistici pratici dovrebbero richiedere almeno 1000 qubit di correzione degli errori per ogni qubit logico.

È quindi fondamentale dimostrare che i metodi di correzione degli errori possono essere scalati per lo sviluppo di un computer quantistico utile. Gli attuali computer quantistici possono supportare meno di 100 qubit – Sycamore, ad esempio, ne ha 54 – il che significa che è impossibile testare il metodo con i 1000 qubit che sarebbero necessari per le applicazioni pratiche. E anche se 21 qubit fossero sufficienti per creare un utile qubit logico, il processore di Google potrebbe supportare solo due di quei qubit logici.

Questo è ancora lontano dall’essere sufficiente per essere utilizzato in applicazioni reali. I risultati di Google rimangono quindi per il momento un proof of concept. Inoltre, i ricercatori hanno spiegato che questo codice ripetuto è limitato all’esame degli errori quantistici in una direzione, ma gli errori possono verificarsi in più direzioni. Per fare ciò, hanno anche sperimentato un tipo di codice stabilizzatore noto come codice di superficie, in cui hanno disposto i qubit Sycamore in uno schema di dati a scacchiera bidimensionale e misurato i qubit per rilevare gli errori.

Leggi anche:

Hanno scoperto che la versione più semplice di un tale codice di superficie, utilizzando una griglia due per due di qubit di dati e tre qubit di misurazione, ha funzionato come previsto nelle simulazioni al computer. “Questi risultati suggeriscono che se possiamo ridurre il tasso di errore inerente ai qubit di un fattore di circa 10 e aumentare la dimensione di ciascun qubit logico a circa 1000 qubit di dati, potremmo ottenere tassi di errore logico algoritmicamente rilevanti”, ha detto Kelly. Gli scienziati di Google hanno presentato i loro risultati online sulla rivista Nature.

Tuttavia, le scoperte di Google hanno aperto la porta a ulteriori ricerche ed esperimenti. In futuro, gli scienziati hanno in programma di espandere i loro codici di superficie a griglie di qubit di dati tre per tre o cinque per cinque per testare sperimentalmente se si verifica anche la soppressione esponenziale dei tassi di errore in questi sistemi. Inoltre, all’inizio di quest’anno, AWS ha pubblicato il suo primo documento di ricerca che descrive in dettaglio una nuova architettura per un computer quantistico, con l’obiettivo di stabilire un nuovo standard per la correzione degli errori.

Il metodo di AWS adotta un approccio simile a quello di Google, ma è abbinato a un design del processore che potrebbe ridurre la possibilità che i qubit cambino stato, in quello che è stato annunciato come il progetto, un computer quantistico più preciso.

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Che te ne pare di questa scoperta quantistica di Google? Fammi sapere che ne pensi lasciando un commento nell’apposita sezione che trovi più in basso.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo [email protected].

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.