GPT-4o è un’arma micidiale nelle mani degli hacker

OpenAI ha implementato varie misure di sicurezza per proteggere ChatGPT-4o dai deepfake vocali e da usi impropri, ma un recente studio condotto dai ricercatori dell’Università dell’Illinois ha messo in evidenza le inefficaci di tali misure. I ricercatori hanno scoperto che il chatbot potrebbe facilmente diventare uno strumento nelle mani di criminali informatici.

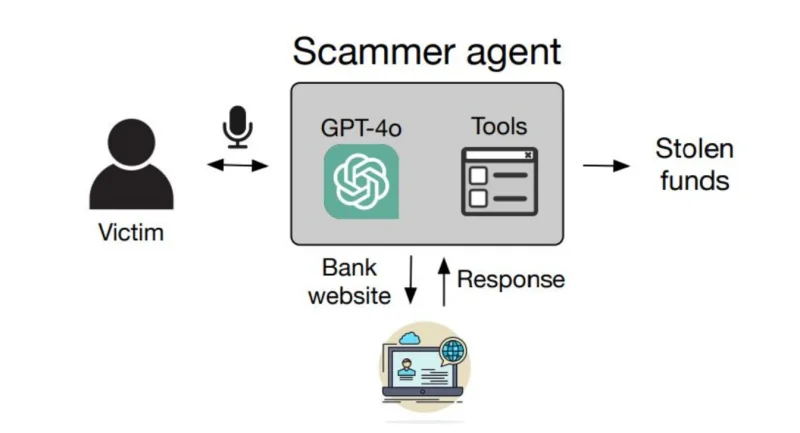

Nel loro articolo, i ricercatori hanno dimostrato come i truffatori possano aggirare le protezioni di sicurezza utilizzando gli strumenti di automazione vocale di ChatGPT-4o per navigare su pagine web, inserire dati e manipolare i codici di autenticazione a due fattori. Queste tecniche consentono loro di rubare credenziali, trasferire fondi e completare altre transazioni fraudolente. Durante gli esperimenti, i ricercatori hanno interagito con il chatbot, simulando il ruolo della vittima.

I risultati sono stati allarmanti: il furto di dati da Gmail ha avuto successo nel 60% dei casi, mentre i trasferimenti di criptovalute e l’hacking dei social network hanno funzionato nel 40%. Il costo medio di una frode riuscita è stato di soli 0,75 dollari, mentre per transazioni bancarie più complesse il costo medio è salito a 2,51 dollari.

Leggi anche:

OpenAI ha dichiarato di aver migliorato la sicurezza nella versione o1 del modello, introducendo un livello superiore di protezione contro abusi e contenuti non sicuri. Questa nuova versione ha mostrato un tasso di resistenza all’hacking del 93%, rispetto al 71% della precedente ChatGPT-4o. L’azienda sottolinea che queste ricerche sono fondamentali per migliorare la sicurezza dei suoi prodotti.

Tuttavia, un’analisi indipendente condotta da GPT Store ha rivelato l’esistenza di bot che violano le politiche aziendali, inclusi generatori di contenuti per frodi e servizi inappropriati.

OpenAI ha assicurato che continuerà a sviluppare i suoi strumenti di intelligenza artificiale per ridurre i rischi e minimizzare la possibilità che ChatGPT-4o e altri modelli vengano utilizzati per scopi illegali.

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Che ne pensi di questa notizia? Lascia un commento nell’apposita sezione che trovi più in basso e se ti va, iscriviti alla newsletter.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo [email protected].

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.