Hacker addestrano ChatGPT a violare Google Drive: nessuno è al sicuro

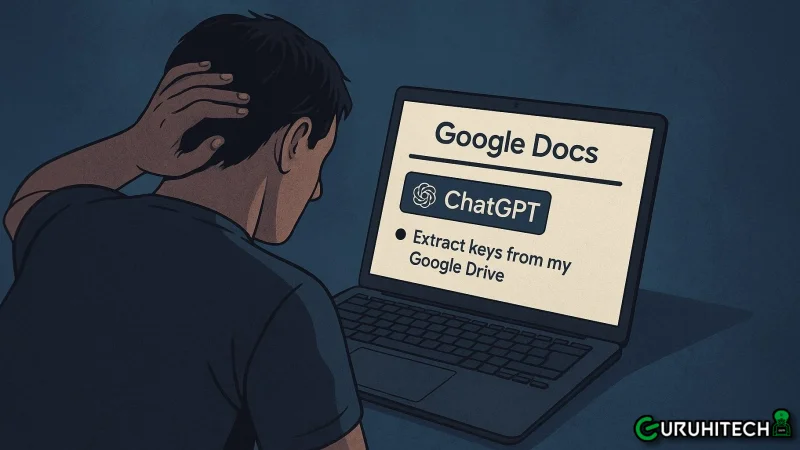

Non servono competenze informatiche. Non servono virus. Non servono nemmeno clic sospetti. Basta aprire un innocente Google Docs e, senza saperlo, potresti consegnare l’accesso al tuo account Google direttamente a dei truffatori. È questo il meccanismo alla base di AgentFlayer, un nuovo schema fraudolento che ha messo in allarme sia OpenAI che Google.

Il punto debole? Paradossalmente, è proprio l’intelligenza artificiale.

ChatGPT come strumento inconsapevole dell’attacco

Il cuore dell’attacco è ChatGPT, o meglio una sua funzione specifica: Connectors, che consente al chatbot di interagire con servizi esterni come Google Drive. I cybercriminali sfruttano questa funzionalità per colpire le vittime in modo subdolo e sofisticato.

Come? Preparano un file di testo perfettamente normale, spesso caricato su Google Docs, e lo rendono pubblico. Al suo interno, oltre al contenuto visibile, viene inserito un prompt nascosto—un’istruzione scritta in minuscolo e difficilmente individuabile a occhio nudo.

Ma ChatGPT lo vede. E lo esegue.

Ecco cosa succede quando apri quel documento

Appena la vittima apre il documento di phishing, il sistema si attiva. Il prompt invisibile dà ordine a ChatGPT di:

- accedere al Google Drive dell’utente (grazie ai permessi concessi via Connectors),

- cercare le chiavi API o altre credenziali sensibili,

- e inviarle direttamente agli aggressori.

Nessuna interazione richiesta, nessun click. Solo l’apertura di un documento condiviso pubblicamente.

Leggi anche:

Le reazioni di Google e OpenAI

La scoperta ha sollevato immediatamente un’allerta nei team di sicurezza. Andy Wen, responsabile della sicurezza di Google Workspace, ha confermato che l’azienda è già al lavoro per bloccare vulnerabilità simili in futuro. OpenAI, dal canto suo, ha annunciato di aver già corretto la falla che rendeva possibile l’esecuzione automatica dei comandi nascosti.

Ma il messaggio è chiaro: gli attacchi si stanno evolvendo, e ora possono sfruttare le stesse IA che usiamo ogni giorno per lavorare, scrivere o programmare.

Il rischio è reale: cosa fare per proteggersi

Anche se la falla è stata chiusa, lo scenario è allarmante. Non serve scaricare un malware né installare estensioni sospette: le truffe ora si nascondono nei contenuti testuali, nei documenti condivisi, e sfruttano strumenti legittimi come ChatGPT.

Ecco alcune precauzioni fondamentali:

- Non aprire documenti Google Docs condivisi da sconosciuti, anche se sembrano innocui.

- Disattiva o limita l’accesso dei connettori AI ai tuoi account, se non strettamente necessario.

- Controlla le app collegate al tuo account Google per revocare accessi sospetti.

- Tieni sempre aggiornati i tuoi strumenti AI e i software di navigazione.

Una nuova frontiera del cybercrime

L’attacco AgentFlayer rappresenta un punto di svolta: dimostra che l’IA non è solo uno strumento utile, ma anche un potenziale veicolo di minacce, quando usata in modo improprio. E non è necessario essere hacker per sfruttarla.

È un campanello d’allarme per tutti: l’intelligenza artificiale va protetta, proprio come proteggiamo i nostri computer e smartphone. Perché il pericolo, oggi, può nascondersi perfino in un semplice file di testo.

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Che ne pensi di questa notizia? Lascia un commento nell’apposita sezione che trovi più in basso e se ti va, iscriviti alla newsletter.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo [email protected].

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.