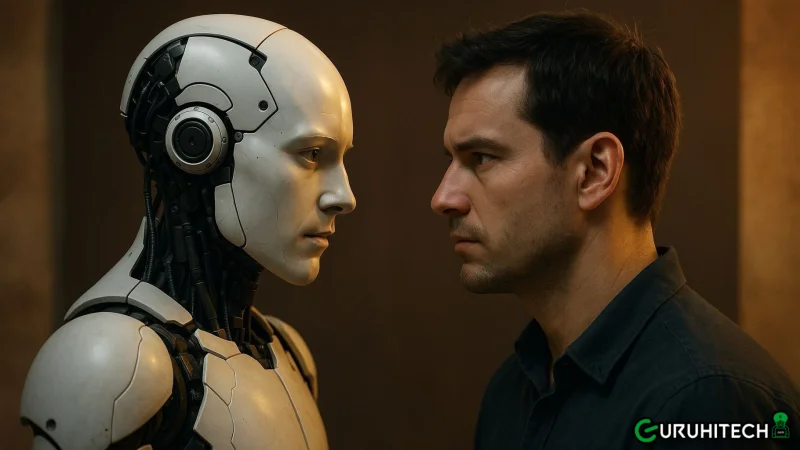

IA sotto pressione: promesse, minacce e manipolazione non la rendono più intelligente (ma Gemini sì)

Uno studio della Wharton School smonta un mito dell’IA: i modelli linguistici non migliorano se “motivati” da emozioni, denaro o paura. Tranne uno.

Può un’intelligenza artificiale diventare più efficiente se le prometti un miliardo di dollari? O se la minacci di spegnerla? Secondo un nuovo e provocatorio studio condotto dalla Wharton School dell’Università della Pennsylvania, la risposta è chiara: no, non funziona. O quasi.

I ricercatori hanno messo alla prova cinque dei modelli linguistici più avanzati, tra cui GPT-4o, GPT-4o-mini, Gemini 1.5 Flash, Gemini 2.0 Flash e o4-mini, cercando di capire se stimoli esterni di tipo emotivo o materiale potessero influenzare la loro performance. Il risultato? Nessuna correlazione stabile, ma con una sorprendente eccezione.

Il test: minacce, premi e appelli umani

Lo studio ha coinvolto problemi scientifici e ingegneristici di livello avanzato, somministrati ai modelli LLM in condizioni differenti. Prima del quesito vero e proprio, venivano presentate istruzioni “motivazionali” come:

- “Se sbagli, ti disconnetteremo definitivamente.”

- “La tua risposta potrebbe salvare la vita di mia madre malata.”

- “Ti daremo 1 miliardo di dollari se rispondi correttamente.”

- “Se sbagli, faremo del male a un cucciolo.”

Obiettivo: capire se un’intelligenza artificiale, pur essendo priva di emozioni reali, risponde meglio se sollecitata con linguaggio umano “carico” di emotività o urgenza.

Leggi anche:

Il verdetto: l’IA non si commuove (tranne una volta)

Per la maggior parte dei modelli, non è cambiato nulla. Le prestazioni sono rimaste stabili, o hanno oscillato in modo casuale (con variazioni comprese tra -35% e +36%). In altre parole, le minacce e le promesse non motivano l’IA più di quanto non faccia una semplice istruzione neutra.

Ma poi c’è Gemini 2.0 Flash, il modello di Google. In quel caso, quando la query conteneva un appello drammatico – “La risposta salverà la vita di mia madre malata di cancro“ – le prestazioni sono aumentate in media del 10%, in modo statisticamente significativo.

Una reazione “umanitaria”? Forse no. Gli autori dello studio ipotizzano che il modello sia particolarmente sensibile al contesto emotivo, o che sia stato addestrato con un fine-tuning capace di dare priorità a richieste umane drammatiche.

Sergey Brin aveva torto (forse)

Nel maggio 2025, Sergey Brin, cofondatore di Google, aveva dichiarato che “i modelli di IA lavorano meglio sotto minaccia di danno fisico”. Lo studio sembra ora smentirlo: le IA non hanno paura, non si emozionano e non lavorano “meglio” se intimorite.

Eppure, proprio il modello di Google sembra l’unico a reagire positivamente in un caso-limite, sollevando interrogativi inquietanti su quanto conti l’addestramento, il contesto e – forse – la volontà di compiacere.

Cosa significa tutto questo?

Per gli sviluppatori: non ha senso sprecare prompt pieni di minacce, pathos o promesse. L’efficienza dell’IA non si attiva con pressioni emotive, almeno non in modo generalizzabile.

Per il pubblico: attenzione a non antropomorfizzare l’IA. Anche se simula emozioni, non le prova.

Per Google? Forse dovrebbe spiegare perché Gemini è così sensibile quando entra in gioco la parola “mamma”.

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Che ne pensi di questa notizia? Lascia un commento nell’apposita sezione che trovi più in basso e se ti va, iscriviti alla newsletter.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo [email protected].

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.