La nuova rete neurale di Google “estrae” la musica dal cervello umano

Google ha già utilizzato l’intelligenza artificiale per creare musica, ma il nuovo sviluppo dell’azienda è interessante per il suo approccio non convenzionale alla risoluzione di questo compito. Il modello di intelligenza artificiale chiamato Brain2Music è in grado di generare una traccia audio basata sull’attività cerebrale dell’utente, “spiando” letteralmente la musica che sta suonando nella loro testa.

Leggi anche:

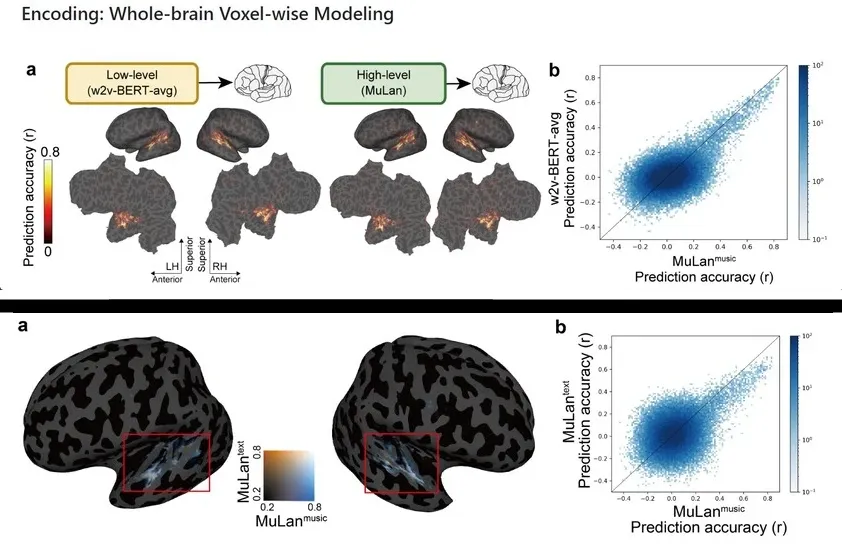

Per creare le composizioni, l’IA si basa sui dati di imaging a risonanza magnetica funzionale (fMRI). Durante l’esperimento, le reti neurali sono state alimentate con i dati fMRI raccolti da cinque persone che hanno ascoltato composizioni musicali di 15 secondi di diversi generi, tra cui blues, classica, country, disco, hip-hop, jazz, metal, pop, reggae e rock. Ciò ha permesso all’IA di stabilire una connessione tra i pattern di attività cerebrale e vari elementi della musica.

I dati elaborati sono poi stati convertiti dall’IA in una traccia audio. Come è emerso, i risultati ottenuti somigliavano in gran parte alle composizioni originali, sebbene fossero notevolmente diversi dai brani originali. È possibile trovare esempi del lavoro del “neuro-compositore” sul sito web ufficiale del progetto. Non è noto se la tecnologia avrà qualche applicazione commerciale.

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Ti piace questa nuova rete neurale di Google? Lascia un commento nell’apposita sezione che trovi più in basso e se ti va, iscriviti alla newsletter.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo [email protected].

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.