Qwen 32B: l’IA di Alibaba che punta a superare DeepSeek e o1 mini

Lo sviluppatore cinese Qwen ha lanciato una rete neurale innovativa, il QwQ-32B, che si distingue per la sua potenza nonostante le dimensioni contenute. Questo modello, appartenente alla categoria del ragionamento, presenta un numero relativamente modesto di parametri, ma riesce a superare il grande DeepSeek R1 da 671 miliardi in vari compiti. Scopriamo in quali scenari il Qwen 32B può rivelarsi utile.

Vantaggi delle dimensioni moderate

L’esecuzione locale di modelli linguistici porta con sé numerosi vantaggi per gli utenti più esperti. Tra questi ci sono la possibilità di lavorare offline, una maggiore privacy grazie all’assenza di comunicazione con il cloud e la flessibilità di adattare il modello alle proprie esigenze. Tuttavia, le prestazioni dipendono dalle specifiche hardware del PC. Su computer avanzati, è possibile eseguire soluzioni con 7-32 miliardi di parametri a una velocità soddisfacente, mentre modelli molto grandi come il DeepSeek R1 richiedono hardware da server.

Il Qwen QwQ 32B rappresenta l’ultima aggiunta alla famiglia di modelli di Alibaba, progettato per affrontare problemi complessi che richiedono un contesto più ampio. Con una finestra di elaborazione ampliata fino a 32.000 token, consente di gestire istruzioni e documenti lunghi fino a circa 24.000 parole. La licenza Apache 2.0 permette l’utilizzo del modello sia per scopi accademici che commerciali senza restrizioni.

Leggi anche:

Confronto con i competitor e prestazioni iniziali

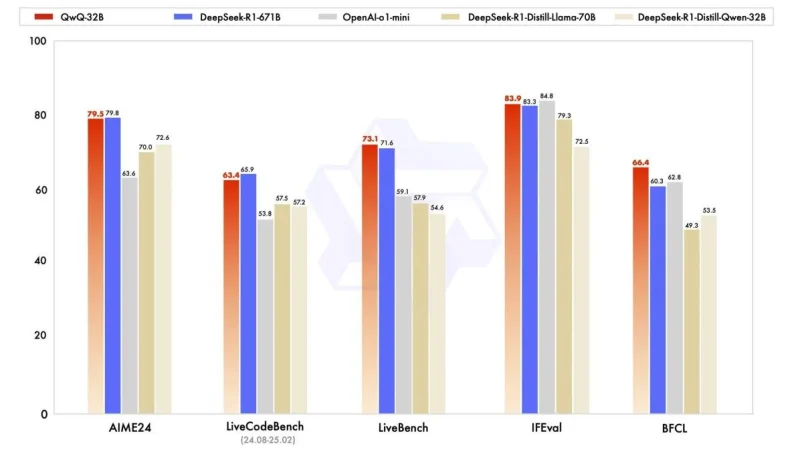

I risultati dei benchmark mostrano che Qwen si allinea bene con il DeepSeek R1. In termini di codice, matematica, coerenza generale e rispetto delle istruzioni, i due modelli sono sostanzialmente equivalenti. Tuttavia, nel campo del fact-checking, il QwQ 32B ha mostrato performance superiori del 6%. Anche rispetto all’altro “mini modello di ragionamento”, l’OpenAI o1-mini, il Qwen ha superato la concorrenza in quattro test su cinque.

Il modello si comporta bene in lingua russa e gestisce correttamente domande complesse, a differenza di altre intelligenze artificiali meno riflessive. È in grado di fornire risposte corrette a quesiti come: “Qual è maggiore: 3,11 o 3,9?” e “Oli ha due fratelli e tre sorelle. Quante sorelle ha il fratello di Olya?” dimostrando solide capacità logiche.

Impostazioni per la generazione di risposte

Per attività che richiedono un elevato livello di precisione, è consigliabile impostare la temperatura (il grado di casualità nella generazione delle parole) in un intervallo tra 0,3 e 0,7. In sintesi, il Qwen QwQ 32B offre un ottimo rapporto qualità/prezzo, rendendolo particolarmente utile per attività dettagliate e complesse come la programmazione e l’analisi di testi voluminosi.

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Che ne pensi di questa notizia? Lascia un commento nell’apposita sezione che trovi più in basso e se ti va, iscriviti alla newsletter.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo [email protected].

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.