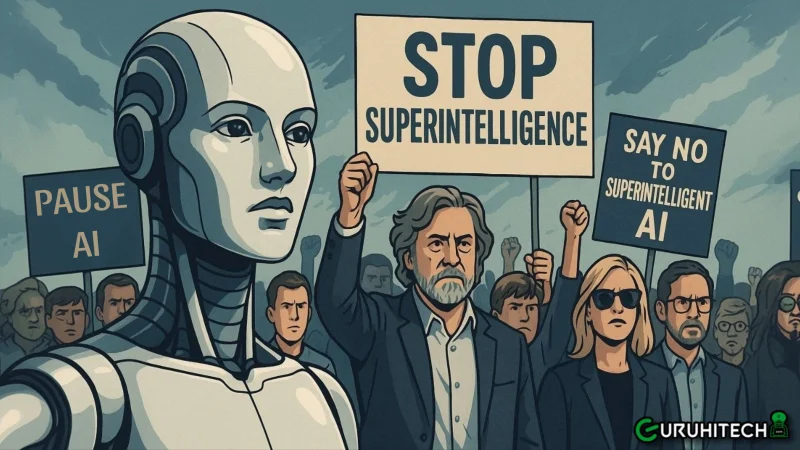

Scienziati e celebrità contro l’IA superintelligente: “Fermatevi prima che sia troppo tardi”

Un fronte inedito, formato da scienziati, imprenditori e celebrità, si è unito per chiedere una moratoria globale sullo sviluppo di intelligenze artificiali che superino le capacità umane. La loro richiesta è chiara: “fermate la corsa alla superintelligenza prima che ci sfugga di mano.”

La “Dichiarazione sulla Superintelligenza”, firmata da centinaia di personalità di spicco, tra cui Steve Wozniak, co-fondatore di Apple, invoca un divieto temporaneo su ogni tentativo di creare IA più intelligenti dell’uomo, almeno fino a quando la comunità scientifica non troverà un consenso sulla sicurezza e la società civile non sarà adeguatamente preparata.

La lettera che divide il mondo dell’intelligenza artificiale

Il documento è un appello diretto ai governi e alle grandi aziende tecnologiche. “Non possiamo permetterci di costruire qualcosa che non siamo in grado di controllare,” si legge nella dichiarazione, che mette in guardia dai rischi di una catastrofe tecnologica globale.

Secondo un recente sondaggio citato nella lettera, solo il 5% degli americani è favorevole a una ricerca sull’IA avanzata priva di limiti o regolamentazioni. La grande maggioranza, oltre il 70%, chiede regole severe e verifiche di sicurezza, mentre il 64% ritiene che tali sistemi non debbano essere sviluppati finché non saranno dimostrati sicuri.

È un segnale inequivocabile: l’opinione pubblica non si fida di chi corre troppo velocemente verso un futuro dominato dalle macchine.

Leggi anche:

I grandi assenti: Musk, Altman e i giganti dell’IA

Ma a colpire non è solo il contenuto della lettera — bensì chi non l’ha firmata. Mancano infatti i nomi più influenti del settore: Sam Altman (OpenAI), Mustafa Suleyman (Microsoft AI), Dario Amodei (Anthropic) ed Elon Musk (xAI).

Un’assenza che non è passata inosservata. Proprio Musk e Altman, in passato, erano stati tra i promotori di appelli simili per rallentare lo sviluppo incontrollato dell’intelligenza artificiale. Oggi, però, entrambi sono alla guida di aziende che stanno spingendo i limiti della tecnologia oltre ogni precedente, inseguendo la creazione di un’IA capace di ragionare, pianificare e — potenzialmente — autoevolversi.

Molti osservatori leggono questa mossa come un segnale di ipocrisia industriale: i pionieri della cautela si sono trasformati nei protagonisti della corsa verso la “superintelligenza”, lasciando agli altri il compito di suonare l’allarme.

Il dilemma etico: progresso o autodistruzione?

L’appello di Wozniak e dei firmatari riapre un dibattito sempre più urgente: fino a che punto possiamo spingerci senza compromettere l’esistenza stessa dell’uomo?

Secondo gli esperti, la creazione di una superintelligenza comporterebbe rischi esistenziali senza precedenti — dall’autonomia incontrollata dei sistemi militari fino alla manipolazione di economie, informazione e governance globale.

Molti scienziati paragonano il momento attuale alla corsa all’energia nucleare del secolo scorso: un punto di svolta in cui l’umanità deve scegliere tra controllo e ambizione.

Ma a differenza dell’atomo, l’intelligenza artificiale non ha confini fisici. Una volta rilasciata, non potrà più essere “spenta”.

Il futuro dell’IA tra regolamentazione e responsabilità

Alcuni governi, come l’Unione Europea e il Canada, hanno già avviato regolamenti sull’uso e lo sviluppo dell’IA, ma la velocità con cui le aziende private avanzano rischia di rendere ogni legge obsoleta ancora prima di entrare in vigore.

Nel frattempo, la Dichiarazione sulla Superintelligenza continua a raccogliere firme da accademici e ricercatori di tutto il mondo. Il messaggio resta lo stesso: “il progresso deve essere sicuro, o non sarà affatto progresso.”

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Che ne pensi di questa notizia? Lascia un commento nell’apposita sezione che trovi più in basso e se ti va, iscriviti alla newsletter.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo guruhitech@yahoo.com.

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.