Apple Intelligence: tutto quello che c’è da sapere!

Negli ultimi tempi, c’è stata molta curiosità su come integrare l’intelligenza artificiale in modo efficace su smartphone e computer. Ieri sera, Apple ha presentato la sua risposta a questa domanda.

Apple ha creato uno stile unico, mirando a prodotti utili, personali e sicuri. Attualmente collabora con OpenAI, prevedendo future partnership. L’obiettivo è la trasparenza e soluzioni non invasive.

La strategia di Apple non è solo aggiungere AI, ma integrarla nell’ecosistema, lavorando con app proprie e di terzi. Spesso, gli sviluppatori non devono fare nulla per adottare le funzioni di Apple Intelligence.

Apple unisce hardware e software per un’intelligenza artificiale sistemica, basata sulla fiducia degli utenti. A Cupertino, si punta su un’AI “personale” che assiste efficacemente, rispettando privacy e sicurezza.

Leggi anche:

Questo approccio mette in evidenza la sfida che altri produttori potrebbero incontrare nel replicare un modello simile, poiché richiede un solido rapporto di fiducia con i clienti, un aspetto in cui pochi hanno avuto successo come Apple. Anche aziende come Samsung, che hanno costruito una buona reputazione con i propri clienti, devono confrontarsi con la presenza di Google come piattaforma di riferimento.

Craig Federighi, Vicepresidente senior di Software Engineering di Apple, ha sottolineato che l’intelligenza artificiale non è una novità per l’azienda, poiché gli iPhone contengono già oltre 200 modelli di machine learning utilizzati da anni per varie funzioni, come il riconoscimento di incidenti, l’organizzazione delle foto e la qualità fotografica.

Una novità da 8GB RAM in poi

Apple Intelligence è potente, flessibile e sicura. Supporta Mac con chip M1 in poi, iPad M e iPhone con A17 Pro.

Non è confermato, ma Apple Intelligence potrebbe richiedere 8 GB di RAM, limitando il supporto ai nuovi iPhone 15 Pro.

I futuri Mac, iPad e iPhone includeranno Apple Intelligence. Anche l’Apple Watch potrebbe integrare l’IA.

La sicurezza è prioritaria. Apple Intelligence opera con dati sul dispositivo e informazioni condivise dalle app per funzioni basate sugli intenti.

I processori degli iPhone, sebbene potenti, non sono in grado di gestire richieste complesse e prolungate in modo autonomo, motivo per cui Apple ha adottato un approccio ibrido che coinvolge anche l’utilizzo del cloud. Questa è una novità per Apple, che tradizionalmente ha sottolineato la protezione dei dati sul dispositivo. Tuttavia, l’architettura dei nuovi server IA è stata progettata con gli stessi standard di sicurezza dell’iPhone, con misure specifiche per garantire la protezione dei dati.

Leggi anche:

Apple ha condiviso dettagli sul funzionamento dei suoi Private Cloud Computers (PCC), e esperti come Matthew Green della Johns Hopkins University hanno elogiato l’approccio di Apple alla sicurezza, posizionandola come un punto di riferimento nel settore.

Apple Intelligence si distingue per la sua approccio unico rispetto ad altre soluzioni AI sul mercato, come le integrazioni AI di Google Pixel o Galaxy AI di Samsung. La differenza fondamentale risiede nel fatto che Apple Intelligence è progettata per essere personalizzata e integrata nell’esperienza utente, utilizzando l’intelligenza artificiale in modo contestualizzato e adattato alle abitudini dell’utente.

Apple ha evitato di creare una semplice copia dei chatbot, poiché riconosce che l’IA deve essere in grado di comprendere le esigenze specifiche degli utenti e interagire in modo personalizzato. Sfruttando la conoscenza dettagliata che ogni utente ha del proprio smartphone, Apple ha creato un’IA personalizzata che si adatta alle esigenze individuali.

Inoltre, Apple ha il vantaggio di sviluppare non solo l’hardware, ma anche i framework su cui gli sviluppatori possono basare le proprie applicazioni. Questo approccio consente ad Apple Intelligence di essere integrata automaticamente in ogni app che utilizza determinati moduli, offrendo un’esperienza uniforme e personalizzata agli utenti.

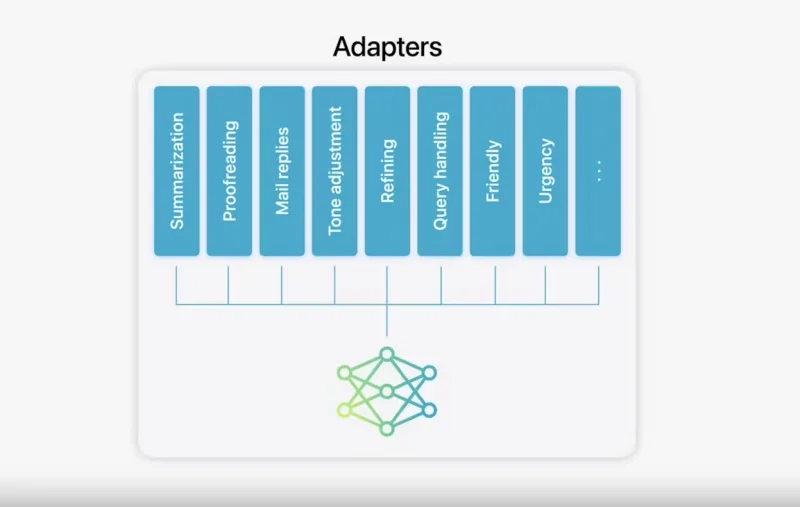

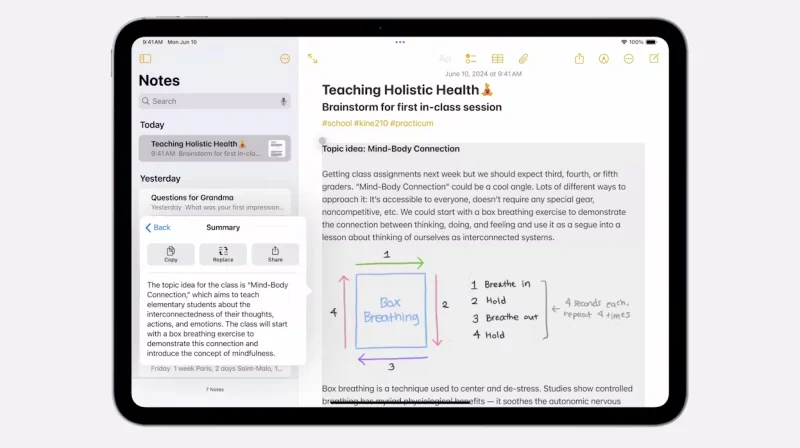

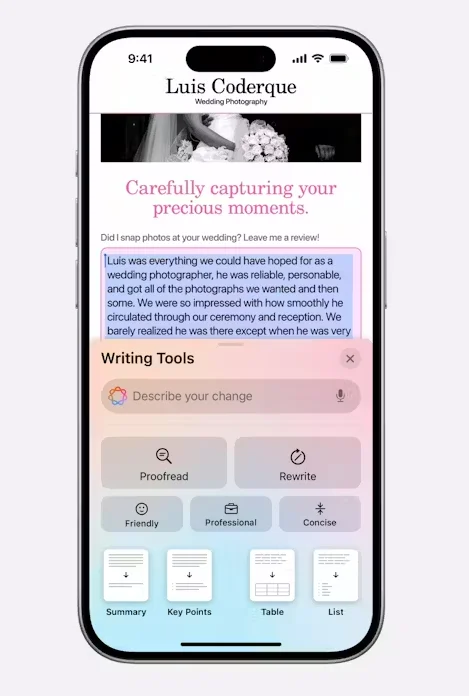

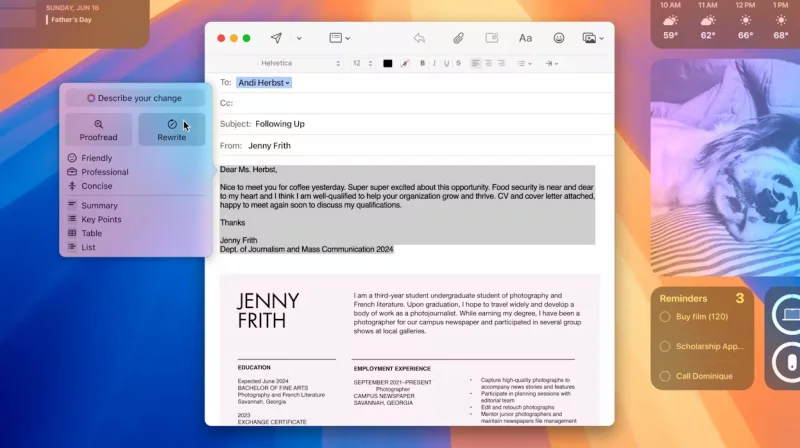

I nuovi strumenti di scrittura, come i Writing Tools, sono integrati a livello di sistema e consentono agli utenti di rielaborare, revisionare e sintetizzare testi in qualsiasi applicazione che preveda l’inserimento di testo, sia che si tratti di Note, Outlook o Gmail.

Questi strumenti appaiono automaticamente quando si inizia a digitare del testo e offrono assistenza nella correzione degli errori ortografici (Proofread), nel riassumere testi già scritti (Summarize) e persino nel riscrivere interi paragrafi o frasi, modificandone il tono per conferire professionalità a una mail o rendere più ironico un messaggio.

L’integrazione di queste funzioni, oltre a essere discreta, è quasi trasparente e riflette un’elevata cura nei dettagli: ad esempio, Proofread controlla la grammatica e la struttura delle frasi, suggerendo modifiche che l’utente può esaminare e accettare, parzialmente o integralmente. In questo modo, l’IA suggerisce e l’utente decide.

Leggi anche:

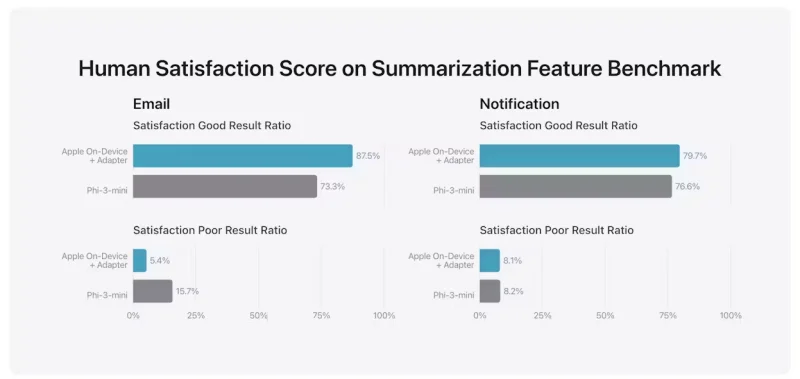

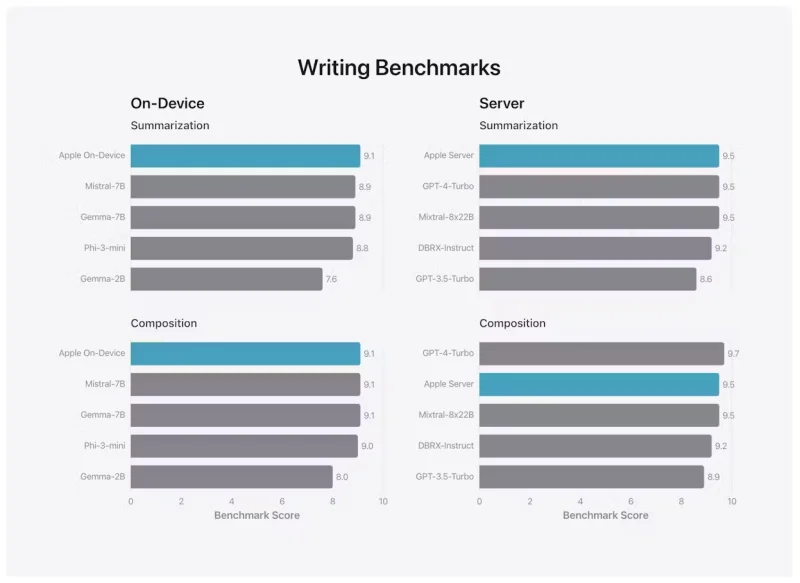

Dove il modello di Apple si distingue, come vedremo più avanti in alcuni benchmark, è nella capacità di riassumere testi. Questa abilità viene sfruttata per sintetizzare brevemente i contenuti delle email, rendendo immediatamente visibile il messaggio ricevuto senza la necessità di aprirlo.

Inoltre, l’IA offre assistenza precisa e puntuale, fornendo suggerimenti rapidi per le risposte tramite Smart Reply e cercando all’interno delle email quelle che contengono domande, garantendo che l’utente non perda nessuna informazione. In caso necessario, vengono proposte risposte adeguate al contesto.

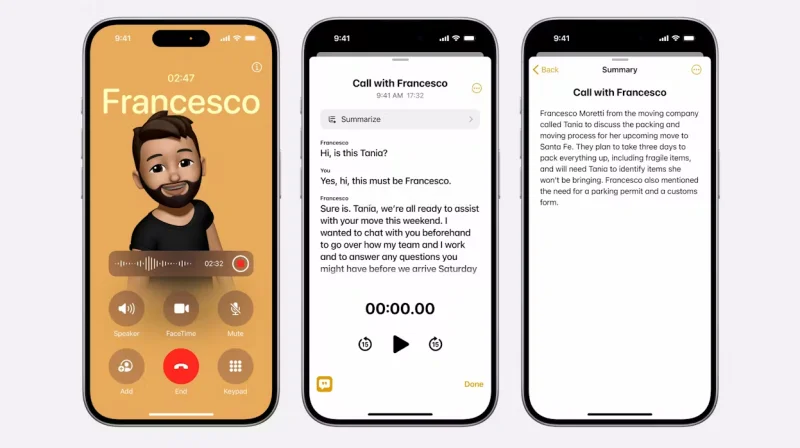

Le nuove funzioni includono la possibilità di trascrivere registrazioni vocali nelle note e di registrare, trascrivere e riassumere le chiamate telefoniche. Durante una chiamata, sia singola che di gruppo, tutte le parti coinvolte vengono informate che la conversazione è registrata.

Oltre al modello LLM per la comprensione e la manipolazione dei testi, Apple ha sviluppato internamente un diffuser, un modello IA progettato per generare immagini da altre immagini o prompt testuali. Questo è stato integrato nell’app Messaggi e reso disponibile come app separata per creare rapidamente schizzi, fotografie e disegni. Tutte le immagini vengono generate on-device, mentre i modelli che richiedono il cloud privato sono quelli legati alla comprensione e manipolazione dei testi.

Image Playground segue lo stesso principio di “personal intelligence”: partendo da una foto, un disegno o una conversazione, suggerisce immagini pertinenti al contesto o divertenti. Questo approccio consente la creazione rapida e pertinente di immagini.

Un ulteriore sviluppo del modello “diffuser” è presente nell’app Note, dove una bacchetta magica nella palette di strumenti di Apple Pencil consente di trasformare schizzi in immagini. Questa funzione richiama l’idea presentata da Microsoft sui PC Copilot+. Inoltre, il modello viene utilizzato per le Genmoji, o Generative Emoji, che possono essere personalizzati e condivisi come sticker.

Leggi anche:

L’accesso alle foto e ai video consente una ricerca più approfondita e accurata, permettendo di cercare immagini specifiche o video in base a descrizioni dettagliate. Inoltre, la funzione Clean Up, che elimina oggetti indesiderati dalle foto, è ora disponibile direttamente nella galleria, senza la necessità di app esterne.

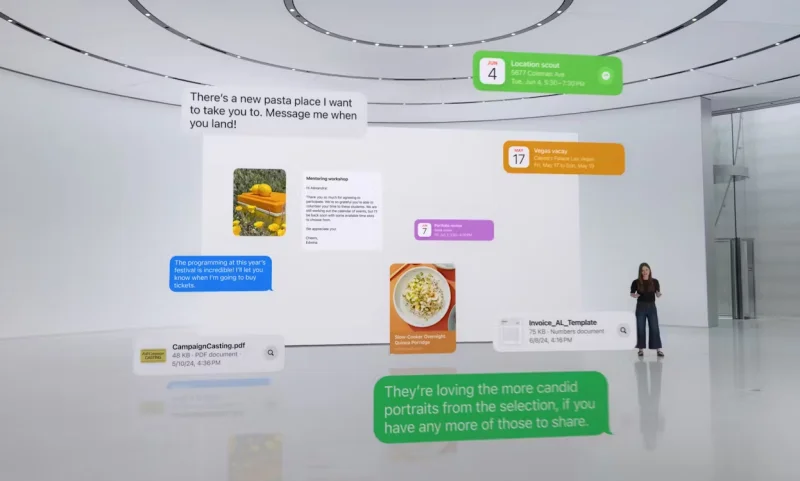

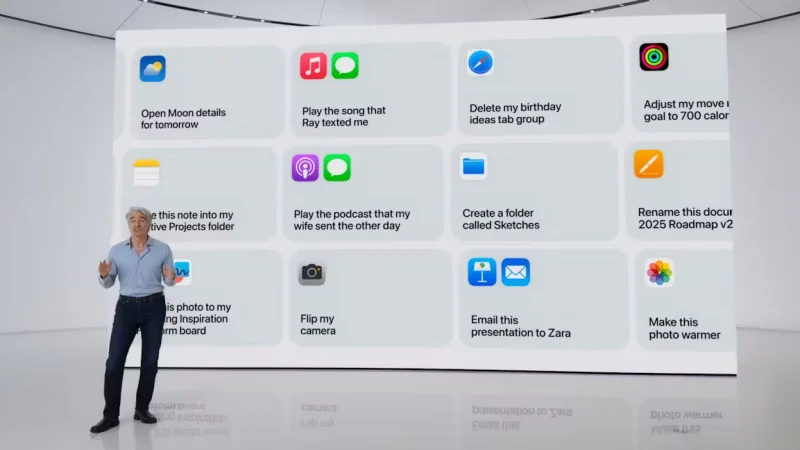

L’integrazione dei nuovi modelli con Siri rappresenta un vantaggio significativo. Il modello da 3 miliardi di parametri, che opera on-device, migliora la capacità di comprensione del linguaggio di Siri, consentendo all’assistente di velocizzare le attività e di seguire l’utente in modo più preciso.

Siri non è solo un assistente vocale, ma consente anche l’interazione tramite la scrittura. L’utente può passare facilmente da una modalità all’altra. Siri può leggere il contenuto sullo schermo e interagire con i dati delle app, a condizione che gli sviluppatori abilitino questa funzione tramite le API.

Questo avanzamento permette a Siri di combinare contenuti da diverse app, offrendo agli utenti un modo più efficiente per completare le attività. Questa capacità di integrare le informazioni da più fonti potrebbe sollevare interrogativi sugli sviluppatori riguardo alla condivisione dei dati delle loro app. Tuttavia, Siri si presenta come un assistente più intelligente e versatile, offrendo un’esperienza utente migliorata.

Apple non è indietro sull’IA? I suoi modelli sono secondi solo a GPT-4.

Apple Intelligence è un prodotto sviluppato internamente da Apple e non si basa su ChatGPT, come alcuni potrebbero pensare leggendo titoli affrettati.

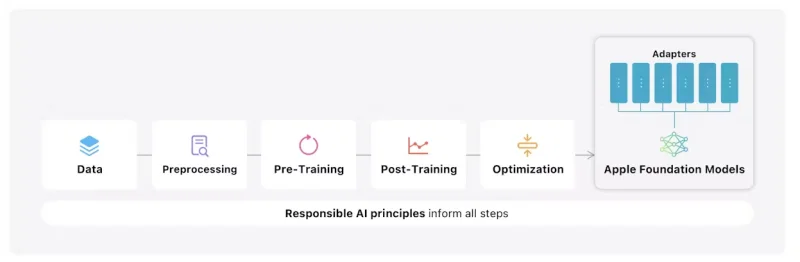

Apple ha addestrato i suoi modelli in-house, infatti, sono diversi modelli, almeno cinque. Ci sono due modelli per la manipolazione del linguaggio identificati come On-Device Foundation Model e Server Foundation Model, il Diffuser per la generazione di immagini, un modello per la traduzione linguistica e un modello per il coding utilizzato in Xcode.

Apple ha condiviso dettagli sui primi due modelli in un lungo documento, rivelando che l’On-Device Foundation Model ha 3 miliardi di parametri ed è progettato per funzionare sul dispositivo sfruttando il Neural Engine, la CPU e la GPU tramite MetalML. Il secondo modello è di dimensioni maggiori, ma Apple non specifica il numero esatto di parametri, e opera sull’infrastruttura Private Cloud Compute.

I modelli sono stati addestrati utilizzando la libreria AXLearn di Apple, con dati provenienti dai web crawler dell’azienda e da banche dati con accordi di licenza. Apple sottolinea che non utilizza e non utilizzerà mai dati personali degli utenti per l’addestramento dei modelli, applicando filtri per rimuovere informazioni sensibili e garantire la qualità dei dati di addestramento.

Dopo una fase accurata di post-training, i modelli sono stati ottimizzati per ottenere risultati ottimali in termini di latenza e velocità.

Leggi anche:

Il modello su dispositivo utilizza un vocabolario di 49K, mentre il modello sul server utilizza un vocabolario di 100K, che include token linguistici e tecnici aggiuntivi. Grazie all’ottimizzazione, su iPhone 15 Pro, Apple ha raggiunto una latenza della prima parola di circa 0,6 millisecondi per token di prompt e un tasso di generazione di 30 token al secondo.

Apple ha gestito la modularità del modello includendo adattatori per scopi specifici come risposte rapide, riassunti e cambi di tono nei testi. Questi adattatori possono essere caricati dinamicamente in memoria, permettendo al modello di specializzarsi per compiti specifici in modo efficiente.

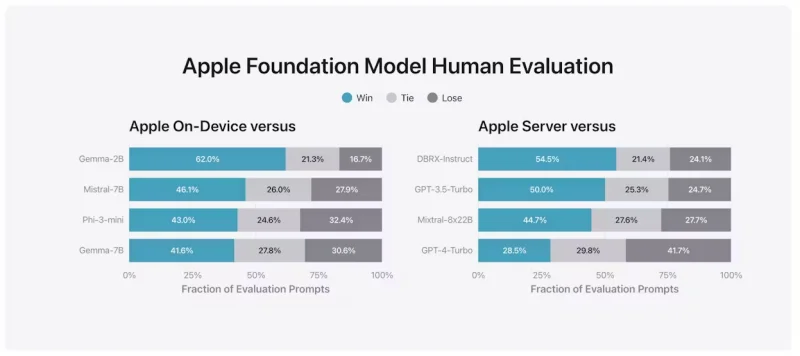

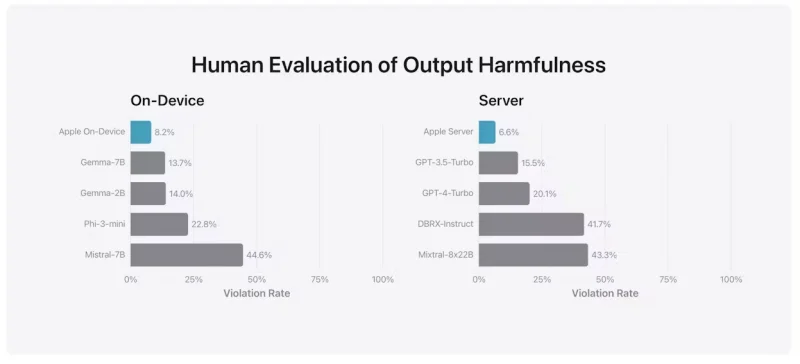

Nei test di performance, il modello su dispositivo ha superato modelli più grandi come Phi-3 Mini, Mistral-7B e Gemma-7B, mentre il modello sul server ha prestazioni paragonabili a Mixtral-8x22B e GPT-3.5-Turbo, ma con maggiore efficienza.

Apple ha anche confrontato i modelli con GPT-4-Turbo e altri modelli open-source e commerciali, dimostrando risultati competitivi. In particolare, Apple ha evidenziato la precisione e la riduzione degli errori nei riassunti dei testi rispetto a Phi-3 Mini.

In generale, i modelli di Apple si sono dimostrati competitivi, superando modelli più grandi in locale e confrontandosi efficacemente con modelli di punta come GPT-4-Turbo. La gestione modulare dei modelli consente una maggiore flessibilità e reattività, senza la necessità di ri-addestrare l’intero modello.

In conclusione, i dati mostrano che Apple non è indietro rispetto ad altri leader del settore come OpenAI, Meta e Google, confermando la solidità e l’efficacia dei suoi modelli di intelligenza artificiale.

Una sessione privata che non lascia tracce, nemmeno per i sistemisti Apple

Nonostante le prestazioni eccellenti del modello in locale in termini di latenza, l’elaborazione di testi estremamente lunghi richiede un tempo di attesa che non soddisfa gli standard qualitativi di Apple.

L’IA deve essere immediata, reattiva e totalmente trasparente: deve completare le attività più velocemente di quanto farebbe una persona. Per garantire rapidità con richieste lunghe, è necessario il supporto del cloud. Apple ha introdotto un nuovo sistema chiamato Private Cloud Compute (PCC) per affrontare le sfide attuali con i sistemi cloud esterni, come la mancanza di crittografia end-to-end nelle chiamate tra client e server.

Per comprendere l’innovazione dietro il concetto di Private Cloud Compute, è importante considerare la complessità della sicurezza informatica. Apple ha adottato misure avanzate per garantire la sicurezza e l’affidabilità dei nuovi server utilizzati nei data center, basandosi sulle tecnologie impiegate per costruire iPhone e Mac.

La sicurezza è una priorità fondamentale per Apple, e i nuovi server si avvalgono di tecnologie come Secure Boot e Secure Enclave Processor (SEP) per garantire la protezione delle chiavi crittografiche. Durante la produzione, ogni componente sui nodi di Private Cloud Computing viene attentamente analizzato e validato per prevenire manomissioni.

Leggi anche:

Ogni server genera un certificato che deve essere convalidato dal client ad ogni richiesta. La comunicazione è crittografata end-to-end e vengono inviati al server solo i dati necessari per una specifica richiesta, garantendo la privacy e la sicurezza dei dati. I dati rimangono sulla memoria del dispositivo solo durante l’elaborazione e vengono cancellati una volta completato il processo.

Apple ha implementato rigorose misure di sicurezza per prevenire attacchi sia hardware che software. Ogni server si riavvia periodicamente, aggiorna le chiavi e cancella lo storage per garantire l’integrità del sistema operativo. Apple certifica che l’immagine del sistema operativo eseguita su ogni server sia autentica, e questa validazione viene confermata da iPhone e Mac ad ogni richiesta.

Apple renderà disponibili le immagini dei server per la verifica da parte dei ricercatori di sicurezza tramite log di trasparenza. Ogni server sarà basato su Apple Silicon e la sicurezza e l’efficienza dei processori contribuiranno agli obiettivi di sostenibilità di Apple per il 2030, inclusa la neutralità carbonica lungo l’intera catena produttiva.

Una piattaforma aperta: ChatGPT è il primo a salire a bordo

Nei mesi scorsi si era parlato di un possibile dialogo tra Apple e società come OpenAI o Google per portare i loro modelli di intelligenza artificiale all’interno dell’iPhone. Tuttavia, Apple ha scelto una strada diversa, sviluppando modelli proprietari sia per l’elaborazione sul dispositivo che per i suoi server.

Nonostante ciò, esistono migliaia di domande alle quali i modelli di “personal intelligence” potrebbero non fornire risposte adeguate. È qui che entrano in gioco i modelli di terze parti, come ChatGPT.

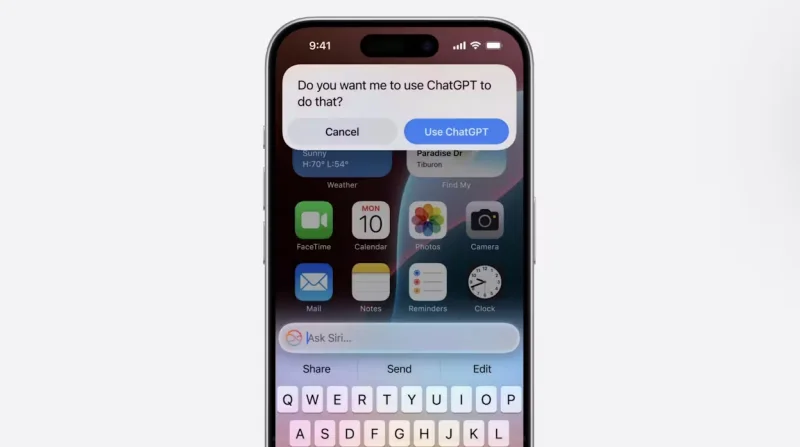

Apple ha adottato una strategia aperta, scegliendo di affidarsi a provider esterni per le ricerche che non richiedono personalizzazione. La scelta è ricaduta su ChatGPT, ritenuto il modello che attualmente offre i migliori risultati per la maggior parte degli utenti. Tuttavia, in futuro potrebbero essere integrati anche modelli come Gemini di Google o altri, per soddisfare esigenze specifiche come la scrittura di codice o la generazione di immagini.

Questa partnership tra Apple e OpenAI rappresenta la versione moderna, in chiave “IA”, della precedente collaborazione tra Apple e Google per il motore di ricerca predefinito dell’iPhone. La ricerca classica sta diventando sempre meno rilevante, mentre sempre più persone si affidano ai chatbot basati sull’intelligenza artificiale. Integrando ChatGPT e altre IA in futuro, Apple eviterà che gli utenti debbano passare da un’app all’altra.

Leggi anche:

Tuttavia, la disparità di trattamento osservata durante il keynote di Apple, con una maggiore enfasi su Ubisoft rispetto a OpenAI, lascia intendere che sia ChatGPT ad aver bisogno di Apple, e non il contrario. Questo potrebbe essere il primo passo di OpenAI per costruire, nell’era dell’IA, ciò che Google ha realizzato con il suo motore di ricerca nel primo web.

In termini di privacy, l’accordo tra Apple e OpenAI prevede alcune garanzie: gli indirizzi IP delle richieste verranno oscurati e OpenAI si impegnerà a non conservare le richieste, almeno per il servizio base gratuito basato su GPT-4. Gli utenti con abbonamento a ChatGPT potranno invece collegare il loro account, con l’applicazione della relativa politica di trattamento dei dati.

Infine, il design language scelto da Apple per l’integrazione di ChatGPT sembra voler scaricare ogni responsabilità per eventuali risposte sbagliate o pericolose, con un chiaro disclaimer che avvisa l’utente della possibilità di errori da parte di ChatGPT.

Una IA diversa, personale e complementare ai modelli più noti. Inutile reinventare la ruota

La descrizione più accurata di Apple Intelligence è stata fornita da Andrej Karpathy, un passato come director of AI in Tesla e membro del team originale di OpenAI.

Apple Intelligence si rivela un prodotto unico nel suo genere, in grado di soddisfare contemporaneamente una serie di principi che nessun altro modello è riuscito a combinare finora.

Innanzitutto, Apple Intelligence è multimodale sia in ingresso che in uscita, gestendo testi, immagini, audio e video senza alcuna frizione. È sempre attiva e disponibile all’interno del sistema, adattando l’interfaccia utente in base al contesto in cui viene richiamata. Non solo è reattiva, ma riesce anche a essere proattiva, suggerendo spesso i prompt che l’utente sta per inserire, come accade nei chatbot tradizionali.

Tutto ciò avviene direttamente sul dispositivo, con la possibilità di delegare parte dei calcoli a un cloud sicuro se necessario. Apple Intelligence è inoltre modulare, sia nel modello che nella gestione di modelli di terze parti, ed è costruita attorno alla tutela dei dati dell’utente.

Questa IA non può essere paragonata agli altri LLM (Large Language Model) perché non è un semplice sostituto, bensì un sistema complementare. Ci sono alcune funzionalità come i riassunti, la rielaborazione dei testi e la creazione di contenuti che si sovrappongono, ma Apple Intelligence non è stata addestrata per coprire l’intero spettro della conoscenza umana, né per specializzarsi in ambiti specifici come linguaggi di programmazione o particolari stili di scrittura.

Leggi anche:

Proprio per questo motivo, Apple ha deciso di affidarsi a modelli esterni, evitando di reinventare la ruota. Questo le permette anche di alleggerire l’infrastruttura server, smistando le richieste che non riguardano il materiale dell’utente su altri modelli.

Tuttavia, rimane da vedere come Apple Intelligence si comporterà nella pratica. Sebbene la demo abbia mostrato funzionalità rivoluzionarie, l’IA può rivelarsi meno prevedibile di un semplice algoritmo. Per questo motivo, Apple lancerà Apple Intelligence in beta con iOS 18, iPadOS 18 e macOS 18, in modo da perfezionarla gradualmente.

Inoltre, al lancio iniziale, il sistema sarà disponibile solo per gli iPhone impostati in lingua inglese. Altre funzionalità e lingue verranno introdotte l’anno successivo, così come l’integrazione con ChatGPT, prevista per una release successiva.

Guarda il video:

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Ti è piaciuto questo articolo sulla nuova Apple Intelligence? Lascia un commento nell’apposita sezione che trovi più in basso e se ti va, iscriviti alla newsletter.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo [email protected].

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.