La nuova IA di Alibaba risolve i problemi matematici meglio di ChatGPT

Alibaba Cloud ha introdotto un nuovo grande modello linguistico open source, denominato Qwen2-Math. Questa piattaforma consiste in un insieme di moduli specializzati, addestrati principalmente in lingua inglese, che dimostrano un’elevata precisione nella risoluzione di problemi matematici di varia complessità.

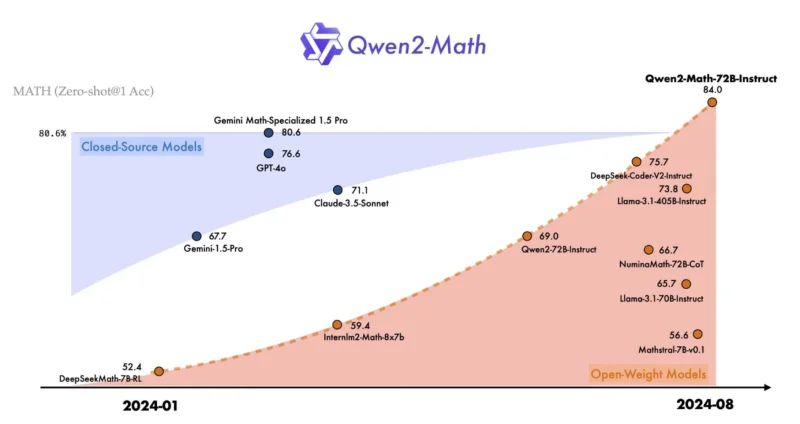

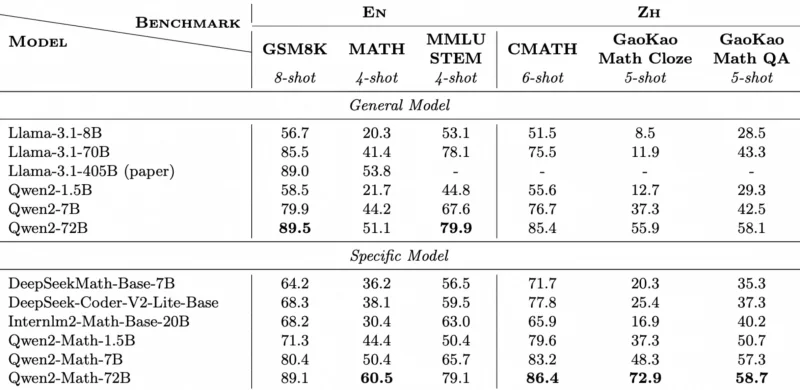

La versione precedente del modello, identificata come Qwen2-Math-72B-Instruct, è risultata di qualità superiore rispetto ai modelli di intelligenza artificiale proposti da aziende come OpenAI, Anthropic e Google. Questo grande modello linguistico (LLM) raggiunge una precisione dell’84% sul benchmark MATH, che include 12.500 problemi matematici impegnativi.

Leggi anche:

Le performance di Qwen2-Math si sono rivelate impressionanti non solo nei test complessi, ma anche nei benchmark incentrati sulla matematica scolastica e universitaria. Ad esempio, la piattaforma ha ottenuto il 96,7% su GSM8K e il 47,8% su College Math.

È interessante notare che anche il modello più compatto di Qwen2-Math, chiamato Qwen2-Math-1.5B, riesce a competere con i LLM di maggiori dimensioni senza essere inferiore a loro nelle capacità di calcolo. Ciò rende Qwen2-Math adatto all’utilizzo da parte di startup, aziende e organizzazioni scientifiche.

In futuro, gli autori di Qwen2-Math intendono aggiungere il supporto per altri linguaggi oltre all’inglese e migliorare ulteriormente il funzionamento degli algoritmi alla base del modello.

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Ti è piaciuta questa notizia? Lascia un commento nell’apposita sezione che trovi più in basso e se ti va, iscriviti alla newsletter.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo [email protected].

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.