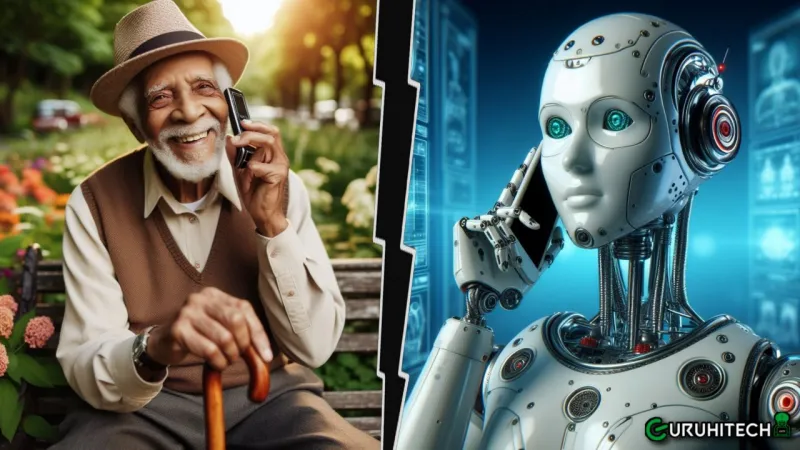

Truffano i genitori con l’intelligenza artificiale: non era sua figlia, ma un robot

Negli ultimi anni, le minacce informatiche sono diventate una preoccupazione sempre più grande per individui e organizzazioni

L’intelligenza artificiale, con la sua capacità di apprendere e adattarsi, si sta rivelando un utile strumento di lavoro, ma anche un valido alleato per i criminali informatici, sempre pronti a truffare il prossimo.

Da un lato, offre strumenti avanzati per proteggere i dati e i sistemi, ma dall’altro viene utilizzata per elaborare truffe sempre più sofisticate e credibili, sfidando le tradizionali misure di sicurezza.

Paddric Fitzgerald si trovava al lavoro quando il suo telefono squillò, era un numero sconosciuto. Al rispondere, si trovò di fronte a una situazione spaventosa. Ha sentito sua figlia urlare in sottofondo durante la chiamata, dicendo di essere in pericolo. “Gridava dicendo che l’avrebbero uccisa mentre era in conversazione. Avrei dato loro tutto quello che ho economicamente”, ha raccontato. In realtà, non si trattava di sua figlia, ma di una voce generata dall’intelligenza artificiale.

Per coincidenza, in quel momento ha ricevuto un messaggio normale da sua figlia sul suo cellulare, il che gli ha fatto capire che la voce che stava ascoltando non apparteneva a sua figlia, ma era stata creata tramite il deepfake vocale. Questo metodo rappresenta la nuova e allarmante strategia che i criminali stanno utilizzando per ingannare le persone.

Leggi anche:

Le voci generate con l’IA rappresentano una minaccia reale

Oggi è comune trovare canzoni create con l’intelligenza artificiale. Ad esempio, è circolata online una canzone di Bad Bunny, Daddy Yankee e Justin Bieber, anche se in realtà questi artisti non hanno mai collaborato, sono solo le loro voci manipolate tramite IA. Era prevedibile che i criminali iniziassero a utilizzare queste tecniche di clonazione vocale per scopi illeciti.

Alex West, consulente presso PwC e coautore di alcuni dei più recenti studi sull’argomento, ha spiegato che “i truffatori stanno già ottenendo un grande successo” e probabilmente stanno appena iniziando a utilizzare questa tecnologia. Ha aggiunto che “è evidente che i tentativi di truffa diventeranno sempre più sofisticati”.

Nel febbraio del 2023, uno studio condotto da ricercatori di Microsoft ha dimostrato le capacità del loro sistema, VALL-E, nel clonare voci con una qualità eccezionale, utilizzando solo un campione vocale di tre secondi. Gli esperti in generazione di contenuti tramite IA, come Henry Ajder, che ha consulenze per aziende come Meta o Adobe, sottolineano come l’IA abbia notevolmente facilitato le truffe di identità.

Secondo i dati della Federal Trade Commission citati da FT, le truffe colpiscono in particolare le persone anziane, con le perdite economiche medie che aumentano con l’età delle vittime. Ad esempio, le persone di età superiore agli 80 anni subiscono perdite che sono il doppio di quelle subite da individui più giovani.

Per proteggersi da queste truffe vocali digitali, è essenziale che le persone convalidino l’identità di chi le contatta tramite un altro canale di comunicazione, assicurandosi che sia veramente chi dice di essere. È inoltre fondamentale non fornire alcun tipo di informazione personale o finanziaria durante chiamate non verificate.

Si consiglia anche di parlare con familiari e amici di queste tecniche di frode, creando una rete di allerta e prevenzione che riduca la vulnerabilità a queste sofisticate truffe tecnologiche.

Ti potrebbe interessare:

Segui guruhitech su:

- Google News: bit.ly/gurugooglenews

- Telegram: t.me/guruhitech

- X (Twitter): x.com/guruhitech1

- Bluesky: bsky.app/profile/guruhitech.bsky.social

- GETTR: gettr.com/user/guruhitech

- Rumble: rumble.com/user/guruhitech

- VKontakte: vk.com/guruhitech

- MeWe: mewe.com/i/guruhitech

- Skype: live:.cid.d4cf3836b772da8a

- WhatsApp: bit.ly/whatsappguruhitech

Esprimi il tuo parere!

Che ne pensi di questa nuova truffa del deepfake vocale? Lascia un commento nell’apposita sezione che trovi più in basso e se ti va, iscriviti alla newsletter.

Per qualsiasi domanda, informazione o assistenza nel mondo della tecnologia, puoi inviare una email all’indirizzo [email protected].

Scopri di più da GuruHiTech

Abbonati per ricevere gli ultimi articoli inviati alla tua e-mail.